AMD新一代AI芯片竞争地位全面分析:对标NVIDIA的战略与前景

解锁更多功能

登录后即可使用AI智能分析、深度投研报告等高级功能

关于我们:Ginlix AI 是由真实数据驱动的 AI 投资助手,将先进的人工智能与专业金融数据库相结合,提供可验证的、基于事实的答案。请使用下方的聊天框提出任何金融问题。

相关个股

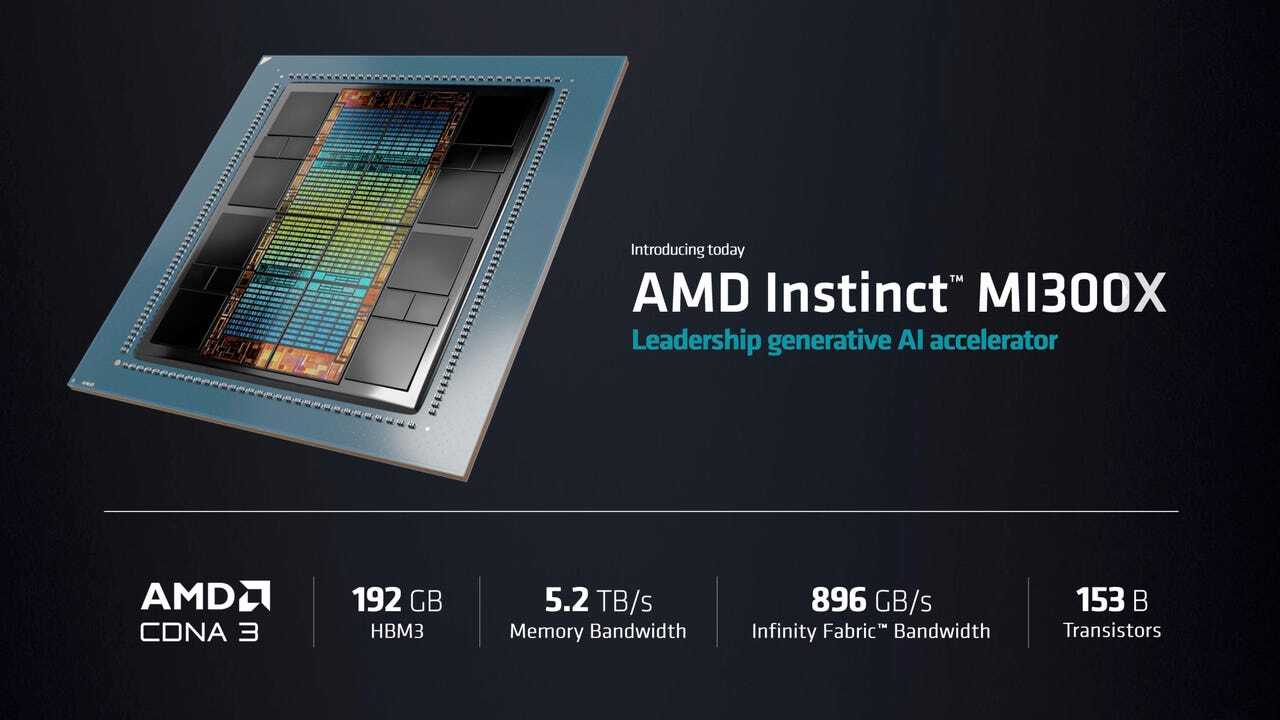

AMD在CES 2024展会上发布的Instinct MI300X代表了其在AI加速器市场的重要技术突破。与NVIDIA H100相比,MI300X在多项关键指标上实现了

- 192GB HBM3高带宽内存,是NVIDIA H100的2.4倍容量[1]

- 5.3 TB/s内存带宽,比H100的3.3 TB/s高出60%[1]

- 这意味着MI300X能够在单芯片上容纳更大的大语言模型(LLM)参数,显著降低多芯片通信开销

- FP64双精度浮点:163.4 teraflops,是H100的2.4倍[1]

- FP32单精度浮点:163.4 teraflops(矩阵和向量运算),是H100的2.4倍[1]

- FP16峰值性能:1,307.4 teraflops,比H100/H200的989.5 teraflops高出32.1%[2]

- 功耗设计:750W TDP(略高于H100的700W)[1]

根据MLPerf基准测试和第三方评测:

- Llama 2 70B推理性能:单MI300X达到2,530.7 tokens/秒,与H100性能相当[2]

- 推理效率优势:凭借更大的内存容量,MI300X能够在单个设备上运行完整模型分片,减少跨设备通信延迟[3]

- HPC工作负载:在高性能计算任务中,MI300X在多个基准测试中"不仅与H100竞争,还可以声称性能领先"[4]

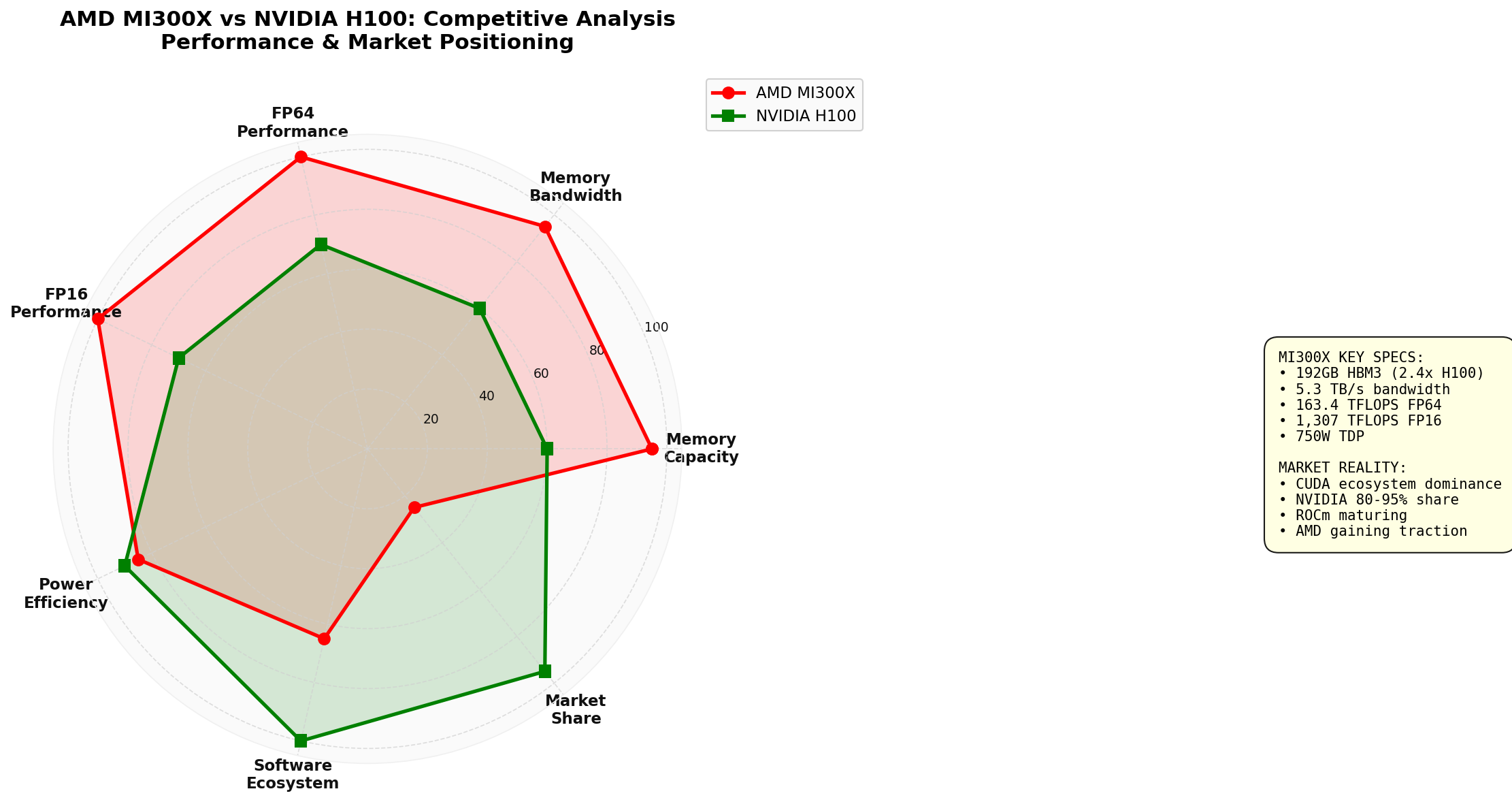

雷达图显示:MI300X在硬件性能指标(内存容量、带宽、计算性能)上全面领先H100,但在软件生态系统和市场份额方面仍有显著差距

AMD在2024-2025年取得了

- Meta:采用MI300X为其4050亿参数的Llama 3.1模型提供动力,据报道订购约17万台设备[3]

- Microsoft:在Azure云服务中部署MI300X,成为重要的战略合作伙伴[5]

- OpenAI:与AMD达成6吉瓦级战略合作协议,部署大规模MI300X集群[5]

- Oracle:在OCI Supercluster中部署5万台MI300X GPU[5]

- 2024年MI300X出货量已超过32.7万台,其中Meta约占一半[3]

- 七家顶级AI公司正在公开部署基于MI300的系统[3]

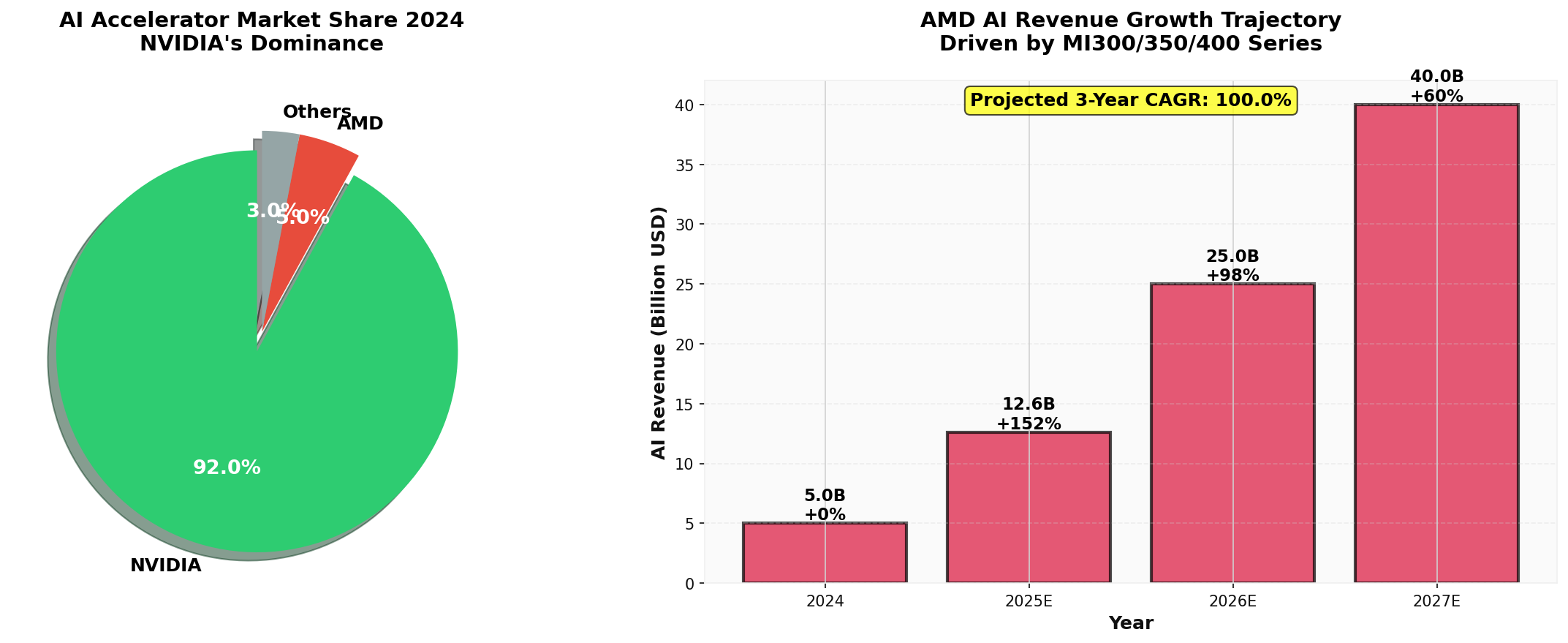

- AMD数据中心AI收入预计从2024年的约50亿美元增长路径明确[3]

尽管取得显著进展,AMD的市场份额与NVIDIA相比仍存在

- 2024年AI GPU市场份额:NVIDIA占据80-95%(其中数据中心GPU份额达92%),AMD仅占个位数份额[6]

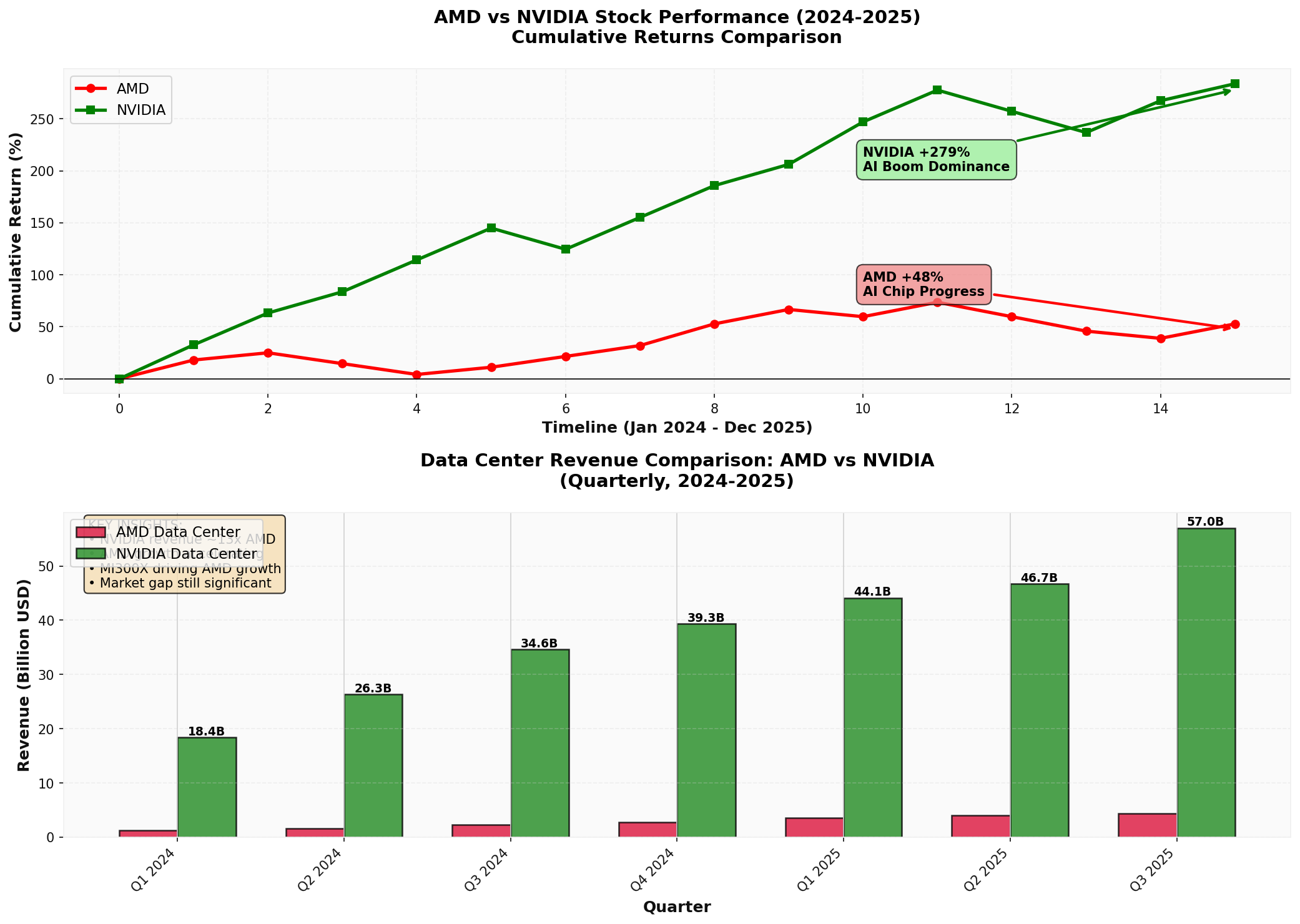

- 数据中心收入对比(2025年Q3):

- NVIDIA:571亿美元

- AMD:43.4亿美元

- 差距约13倍[0]

- NVIDIA:

- 市值差距:NVIDIA(4.58万亿美元)vs AMD(3588亿美元),相差近12倍[0]

左图:2024年AI加速器市场份额显示NVIDIA的压倒性优势;右图:AMD AI收入增长轨迹显示强劲上升势头,预计3年CAGR达102%

NVIDIA的真正优势不仅在于硬件,更在于其

- 成熟的库优化:高度优化的深度学习框架集成和库支持[7]

- 广泛的开发者基础:数百万开发者熟练掌握CUDA编程

- 企业级支持:完善的工具链、调试器和性能分析工具

- 并发性能优势:在高强度并发请求场景下,CUDA执行栈展现出更好的可扩展性[7]

- 尽管MI300X在纸面参数上超越H100,但在实际SaaS环境中,软件成熟度而非原始算力成为性能主导因素[7]

- ROCm平台在并发基准测试中出现性能平台期,而CUDA能持续扩展吞吐量[7]

AMD的ROCm软件栈虽然起步较晚(2016年发布),但正在

- 开源透明性:开发者可以检查、修改和贡献系统的每一层[8]

- 成本优势:AMD硬件价格普遍低于NVIDIA同类产品15-40%,为预算敏感项目提供吸引力[8]

- 快速进步:ROCm 6.1.2版本在PyTorch框架上的兼容性显著改善[2]

- 顶级客户(Meta、Microsoft、OpenAI)的采用验证了ROCm的生产就绪性[3,5]

- AMD持续投资ROCm开发,库优化和框架集成正在加速

上图显示NVIDIA在AI浪潮中占据主导地位(+279%),AMD虽然取得进展(+48%)但明显落后;下图反映数据中心收入的巨大差距

- NVIDIA:从49.24美元涨至186.50美元,涨幅**+278.76%**

- AMD:从144.28美元涨至214.16美元,涨幅**+48.43%**

- 市场对NVIDIA在AI芯片领域的主导地位给予了压倒性认可

- NVIDIA P/E:46.13x(市值4.58万亿美元)

- AMD P/E:108.73x(市值3588亿美元)

- 12倍的市值差距反映市场认为NVIDIA的地位难以撼动

- AMD的高P/E(108.73x)表明投资者对其高增长预期

- 任何动摇NVIDIA霸权叙事的证据都将重新定位两只股票的估值[6]

- 35倍推理性能提升(相比MI300X)[9]

- 288GB HBM3E内存(进一步扩大容量优势)[9]

- 已获得Microsoft、Meta和OpenAI的部署承诺[9]

- 目标直指NVIDIA Blackwell B200

- 预计在2026年开始贡献收入[3]

- 2025年:约3950亿美元(同比增长55%)

- 2026年:约6020亿美元(同比增长34%)

- 2027年:约6150亿美元(同比增长16%)[10,11]

- 约75%的资本支出将用于AI基础设施

- 2026年AI特定支出约4500亿美元[10]

- 即使AMD获得10-15%的市场份额,也意味着数百亿美元的收入机会

根据AI-2027研究机构预测:

- 全球AI相关计算总量将从当前的1000万H100等效单位增长至2027年底的1亿H100等效单位

- 年复合增长率2.25倍[11]

- 这为AMD提供了巨大的市场扩张空间

-

CUDA生态系统锁定:

- 企业迁移成本高(代码重写、人员培训、工具链更新)

- 现有投资保护倾向

-

供应链限制:

- HBM3E内存供应紧张

- 先进封装产能瓶颈

- 台积电CoWoS产能竞争

-

客户自研芯片:

- Google TPU、AWS Trainium、Meta可能的定制芯片

- 长期可能压缩第三方市场空间

AMD的MI308向中国出口受到

✅

- 硬件性能领先:MI300X在关键指标上超越H100,证明技术可行性

- 客户突破:获得Meta、Microsoft、OpenAI等顶级客户验证

- 收入增长:数据中心AI收入从2024年的50亿美元快速上升

- 产品路线图:MI350/MI400显示持续创新承诺

❌

- 市场份额仍低:在NVIDIA主导的市场中份额仍为个位数

- 软件生态差距:ROCm虽在进步,但与CUDA仍有差距

- 收入规模差距:数据中心收入仅为NVIDIA的1/13

- 估值差距:市值差距反映市场对NVIDIA护城河的认可

- AI收入达到100-150亿美元级别

- 市值可能向5000-8000亿美元靠拢

- 成为AI芯片市场的有力竞争者

- AI收入达到60-100亿美元

- 维持当前估值倍数

- 成为可靠的第二选择

- 市场被NVIDIA和云服务商自研芯片挤压

- AI收入增长放缓

- 估值承压

- 关注ROCm生态进展和开发者采用率

- 追踪MI350/M400的出货量和客户反馈

- 监控数据中心收入增长率和毛利率

- 关注超大规模客户的资本支出方向

- 2025年中期:MI350系列发布和初期部署

- 2025年Q4:评估MI300X全年出货量和收入贡献

- 2026年:MI400系列竞争力验证

AMD的新一代AI芯片战略在

- 硬件优势明显但市场渗透缓慢:性能领先转化为市场份额需要时间

- 软件生态是关键战场:ROCm需要持续投资才能缩小与CUDA的差距

- 客户采用正在发生:Meta、Microsoft、OpenAI等胜利提供了强大的验证

- 市场机会巨大:超大规模云服务商的资本支出爆炸式增长为AMD提供了充足空间

对标NVIDIA的策略

对于投资者而言,AMD提供了一种

[0] 金灵API数据 - AMD和NVIDIA公司概况、财务数据、股价表现(2024-2025年)

[1] NetworkWorld - “AMD launches Instinct AI accelerator to compete with Nvidia” (2024年1月) - MI300X技术规格与H100对比数据

https://www.networkworld.com/article/1251844/amd-launches-instinct-ai-accelerator-to-compete-with-nvidia.html

[2] The Next Platform - “The First AI Benchmarks Pitting AMD Against Nvidia” (2024年9月) - MLPerf基准测试结果分析

https://www.nextplatform.com/2024/09/03/the-first-ai-benchmarks-pitting-amd-against-nvidia/

[3] Seeking Alpha - “AMD’s MI350: The AI Accelerator That Could Challenge Nvidia’s Dominance in 2026” (2025年12月) - 市场份额、客户采用和产品路线图

https://seekingalpha.com/article/4856532-amds-mi350-ai-accelerator-that-could-challenge-nvidias-dominance-in-2026

[4] Tom’s Hardware - “AMD MI300X performance compared with Nvidia H100” (2024年10月) - 第三方性能评测

https://www.tomshardware.com/pc-components/gpus/amd-mi300x-performance-compared-with-nvidia-h100

[5] MLQ.ai - “AI Chips & Accelerators Research” (2025年) - 客户部署案例和数据中心收入数据

https://mlq.ai/research/ai-chips/

[6] FinancialContent Markets - “NVIDIA: Powering the AI Revolution and Navigating a Trillion Dollar Future” (2025年12月) - 市场份额统计

https://markets.financialcontent.com/stocks/article/predictstreet-2025-12-6-nvidia-powering-the-ai-revolution-and-navigating-a-trillion-dollar-future

[7] AI Multiple Research - “GPU Software for AI: CUDA vs. ROCm in 2026” (2026年) - 软件生态系统深度对比

https://research.aimultiple.com/cuda-vs-rocm/

[8] Thundercompute - “ROCm vs CUDA: Which GPU Computing System Wins” (2025年) - 开源优势分析

https://www.thundercompute.com/blog/rocm-vs-cuda-gpu-computing

[9] Christian Investing - “AMD Q2 2025: Built to Win the AI Wars” (2025年8月) - MI350规格和客户承诺

https://christianinvesting.substack.com/p/amd-q2-2025-built-to-win-the-ai-wars

[10] CreditSights - “Technology: Hyperscaler Capex 2026 Estimates” (2025年) - 云服务商资本支出预测

https://know.creditsights.com/insights/technology-hyperscaler-capex-2026-estimates/

[11] AI-2027 - “Compute Forecast” (2025年) - AI计算总量增长预测

https://ai-2027.com/research/compute-forecast

[12] LinkedIn - “ROCm vs. CUDA: A Practical Comparison for AI Developers” (2025年) - 开发者视角对比

https://www.linkedin.com/pulse/rocm-vs-cuda-practical-comparison-ai-developers-rodney-puplampu-usbuc

数据基于历史,不代表未来趋势;仅供投资者参考,不构成投资建议

关于我们:Ginlix AI 是由真实数据驱动的 AI 投资助手,将先进的人工智能与专业金融数据库相结合,提供可验证的、基于事实的答案。请使用下方的聊天框提出任何金融问题。