仁宝在2025年OCP全球峰会上发布搭载NVIDIA HGX B300的SGX30-2人工智能服务器

解锁更多功能

登录后即可使用AI智能分析、深度投研报告等高级功能

关于我们:Ginlix AI 是由真实数据驱动的 AI 投资助手,将先进的人工智能与专业金融数据库相结合,提供可验证的、基于事实的答案。请使用下方的聊天框提出任何金融问题。

相关个股

本分析基于仁宝在2025年OCP全球峰会上发布的新闻稿和产品展示[1],代表仁宝电子向高性能人工智能服务器市场迈出的重要战略举措。该活动于2025年10月16日举行,正值人工智能工作负载对数据中心基础设施提出前所未有的需求之际[1]。

SGX30-2服务器的发布表明,仁宝通过集成解决方案全面应对人工智能基础设施挑战,该方案将NVIDIA的HGX B300平台与Blackwell Ultra GPU、基于CXL的内存池、RDMA网络和先进液冷技术相结合[1][2][3]。这一集成堆栈涵盖从芯片级计算到机架级热管理,针对超大规模人工智能部署面临的主要限制:计算密度、内存带宽和能效。

此次发布的时机与全行业转型相契合。主要咨询公司预测,由于人工智能工作负载,数据中心功耗将大幅增加,液冷市场到2030年的复合年增长率预计为27.6%[4][5][6]。仁宝强调pPUE低于1.1的目标,直接应对这些新出现的能效要求。

- 技术采用壁垒:CXL网络成熟度和液冷运营专业知识仍是企业采用的挑战[1][2]

- 供应链限制:Blackwell Ultra GPU和HBM3e模块供应有限可能限制生产规模扩大[3][8]

- 设施准备情况:数据中心运营商需要对液冷和更高功率密度进行重大基础设施升级[4][5]

- 竞争响应:老牌人工智能服务器供应商可能加速推出自己的集成解决方案,增加竞争压力[8][9]

- 先发优势:CXL和液冷与HGX B300的早期集成可能为超大规模企业赢得设计订单[1][2]

- 市场增长:液冷市场预计从2024年的49亿美元增长到2030年的213亿美元[4]

- 能效溢价:在能源受限市场,pPUE低于1.1的目标可获得溢价定价[1][5]

- 生态系统领导力:早期采用使仁宝成为人工智能基础设施集成领域的思想领导者[2][3]

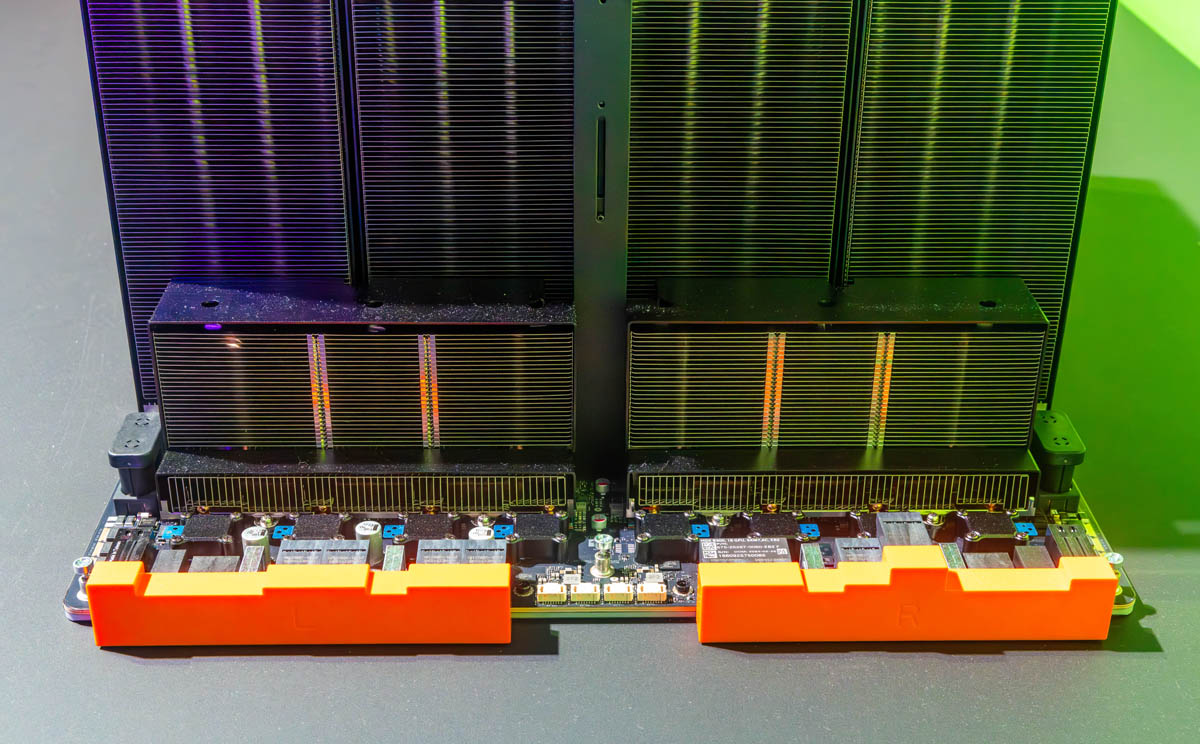

仁宝的SGX30-2发布是对人工智能驱动的数据中心挑战的全面回应,将NVIDIA的HGX B300平台与先进内存和冷却技术相结合。该服务器支持8个Blackwell Ultra GPU,配备基于CXL的内存池,并提供直冷芯片和浸没式冷却选项,目标pPUE低于1.1[1][2][3]。

此次发布标志着仁宝向更高利润的人工智能服务器集成领域的战略扩张,在与老牌OEM厂商直接竞争的同时,利用其制造规模。该集成解决方案解决了限制人工智能部署规模的关键行业限制:计算密度、内存带宽和能效[4][5][6]。

行业预测表明,此类集成解决方案的需求正在加速增长,液冷采用率快速上升,人工智能工作负载导致的数据中心功耗显著增加。仁宝方案的成功将取决于技术成熟度、供应链可用性以及客户设施对先进冷却和电力基础设施的准备情况[4][5][6]。

此次发布反映了更广泛的行业趋势,即向解耦内存架构、液冷采用和集成人工智能基础设施解决方案发展,这些解决方案为超大规模运营商降低了部署复杂性[1][2][3][4]。

数据基于历史,不代表未来趋势;仅供投资者参考,不构成投资建议

关于我们:Ginlix AI 是由真实数据驱动的 AI 投资助手,将先进的人工智能与专业金融数据库相结合,提供可验证的、基于事实的答案。请使用下方的聊天框提出任何金融问题。