数据中心PUE 1.45节能技术突破点深度分析

解锁更多功能

登录后即可使用AI智能分析、深度投研报告等高级功能

关于我们:Ginlix AI 是由真实数据驱动的 AI 投资助手,将先进的人工智能与专业金融数据库相结合,提供可验证的、基于事实的答案。请使用下方的聊天框提出任何金融问题。

根据最新的行业数据和技术发展趋势,我为您系统分析数据中心PUE 1.45目标下的节能技术突破点。

根据国家发展改革委等部门于2024年7月发布的《数据中心绿色低碳发展专项行动计划》,明确要求到2025年底全国数据中心平均电能利用效率(PUE)降至

根据行业测试数据,

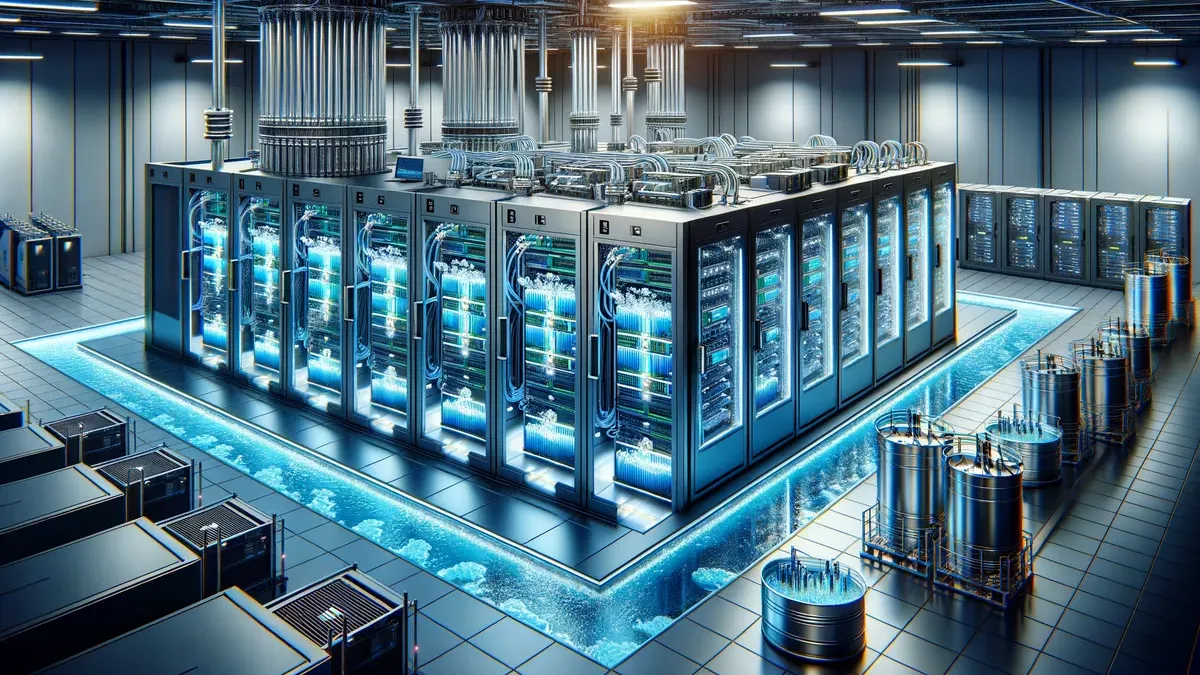

液冷技术是当前数据中心节能领域最具革命性的技术突破,其核心价值在于突破传统风冷的物理极限的同时更加节能环保。

- 液体(如水)的比热容是空气的3500倍,导热能力是空气的25倍[3]

- 可直接接触热源(如芯片),避免空气传导的多层热阻

- 单个NVIDIA H100 GPU功耗达700W,AI服务器机柜功率密度突破30kW(传统风冷极限为15-20kW),而液冷可承载50kW+/机柜的散热需求[3]

| 制冷技术 | PUE值 | 节能效果 |

|---|---|---|

| 传统风冷 | 1.5+ | 基准 |

| 液冷技术 | 1.05-1.1 | 节省30%以上电力[3] |

| 先进液冷系统 | 1.12以下 | 降低服务器功耗30%[4] |

- 直接接触式液冷(Direct-to-Chip):通过高导热液体直接吸收芯片热量

- 浸没式液冷(Immersion Cooling):将服务器完全浸没在特殊冷却液中

实际案例显示,某大型数据中心采用浸没式液冷系统后,PUE从1.8降低到1.2[5]。国科超算公司发布的液冷服务器解决方案,PUE可降至1.12以下,服务器功耗降低30%[4]。

华为廊坊数据中心实测案例显示,采用基于AI的端到端能效管理技术后,全年PUE由

- iCooling技术:基于AI的端到端能效管理,对数据中心能效"看诊调优"

- iManager技术:智能运维管理

- 业务调度与削峰填谷:运用AI技术使服务器负载均衡,提升资源利用率

- 可降低PUE8%[6]

- 实现大型数据中心从"制冷"向"智冷"的转变

- 室外冷风经过滤后送进机房,换热后经热通道从楼顶排出[7]

- 内蒙古乌兰察布数据中心集群利用当地年均气温2.3℃的自然条件,全年节省空调能耗40%[8]

- 利用瀑布和湖水冷却实现部分自然冷却

- 通过热回收技术给泳池和办公区冬季供热,实现余热再利用,减少碳排放[7]

- 国网北京数据中心通过封闭热通道+氟泵热管制冷技术,利用自然冷源将PUE值降低15%[8]

- 北京某数据中心将机房余热用于周边居民供暖,相当于每年减少3000吨碳排放[8]

- 冷量优先控制法:通过实时监测供回水温差与流量,计算实际冷负荷。某实测案例显示,该策略使机组综合能效提升12%[9]

- 动态启停算法:根据室外湿球温度预测未来2小时负荷变化。该算法使某金融数据中心年节省制冷电耗87万kWh[9]

- 冬季自然冷却模式:当湿球温度低于5℃时,启用板式换热器直接冷却。某北方数据中心采用三级换热设计,实现-15℃环境温度下完全自然冷却[9]

- 过渡季混合模式:在10-15℃湿球温度区间,采用部分机械制冷+自然冷却,可延长自然冷却时间400小时/年[9]

- 大温差运行方案:将供回水温差从5℃提升至8℃,使流量减少37%。某运营商数据中心水泵能耗下降52%[9]

- 智能模块化数据中心:相比于业界数据中心,全生命周期内可节省电量7000万千瓦时(10MW数据中心,负载率40%,业界数据中心平均PUE 1.6)[6]

- 模块化UPS效率:高达97.5%,业界领先,同比业界96%效率UPS[6]

- iPower技术:通过供配电全链路监测、预警和故障自动隔离等手段,提升供配电系统可靠性[6]

液冷技术另一重要突破在于

- 液冷出水温度可达60℃以上(风冷废热仅30-40℃)

- 可直接用于区域供暖或工业用热,实现能源复用,提升综合能效至90%+[3]

- 某互联网公司引入服务器虚拟化技术后,将原本需要100台物理服务器的业务负载整合到20台高性能服务器上

- 服务器数量减少80%,服务器能耗降低约60%[5]

针对PUE 1.45目标,建议采用以下技术组合:

| 技术领域 | 具体措施 | 预期PUE贡献 |

|---|---|---|

| 制冷系统 | 液冷技术(直接接触式或浸没式) | 降至1.1-1.2 |

| 智能管理 | AI能效管理(iCooling) | 降低8-10% |

| 自然冷却 | 直通风+中温冷冻水 | 降低15-20% |

| 水力优化 | 变频水泵+大温差运行 | 降低5-8% |

| 供配电 | 模块化UPS+智能监测 | 降低3-5% |

-

政策刚性约束:欧盟《能效指令》要求2030年数据中心PUE<1.3(仅液冷可实现);中国"东数西算"工程强制新建数据中心PUE≤1.25[3]

-

液冷技术普及:预计2025年数据中心耗电量占全球总量4.5%且年增12%,液冷将成为AI服务器的"黄金赛道"[10]

-

AI深度融合:从"制冷"向"智冷"转变,基于数字孪生的能效优化将成为标配

[1] 新京报 - 《两会声音李俊林:建议加快出台数据中心碳减排方法学》 (https://www.bjnews.com.cn/detail/1741427077168706.html)

[2] 雪球 - 《2025年数据中心能效新规实施》 (https://xueqiu.com/6157001146/329030034)

[3] 网易 - 《液冷技术是未来数据中心发展的必然选择》 (https://www.163.com/dy/article/JO1HE55A0538B4E3.html)

[4] 网易 - 《引领计算新趋势:国科超算推出高效液冷服务器》 (https://www.163.com/dy/article/JROS1NFL0547MCUN.html)

[5] 原创力文档 - 《数据中心节能降耗技术应用实例》 (https://max.book118.com/html/2025/0206/8131053005007030.shtm)

[6] 中国IDC圈 - 《工信部等三部门联合发文要求PUE低于1.4,华为以行践言》 (http://app.idcquan.com/mobile.php?contentid=159208)

[7] 华为官网 - 《华为云围绕PUE持续改进能效,建设绿色数据中心》 (https://www.huawei.com/cn/sustainability/the-latest/stories/green-data-centers-optimal-pue)

[8] 今日头条 - 《冷知识预警!空调耗电竟比数据中心高?》 (https://www.toutiao.com/article/7477555199474434597/)

[9] 北京中测信通科技 - 《数据中心冷水机组节能运行策略解析》 (http://www.zcecs.com/yenei/2726.html)

[10] 东方财富网 - 《为什么说液冷是AI服务器的黄金赛道》 (http://caifuhao.eastmoney.com/news/20250126141317760543990)

数据基于历史,不代表未来趋势;仅供投资者参考,不构成投资建议

关于我们:Ginlix AI 是由真实数据驱动的 AI 投资助手,将先进的人工智能与专业金融数据库相结合,提供可验证的、基于事实的答案。请使用下方的聊天框提出任何金融问题。