谷歌TPU v5芯片量产进度及与英伟达H100算力成本对比分析

解锁更多功能

登录后即可使用AI智能分析、深度投研报告等高级功能

关于我们:Ginlix AI 是由真实数据驱动的 AI 投资助手,将先进的人工智能与专业金融数据库相结合,提供可验证的、基于事实的答案。请使用下方的聊天框提出任何金融问题。

根据收集到的最新信息,我来为您详细分析谷歌TPU v5芯片的量产进度及其与英伟达H100的算力成本对比。

| 型号 | 发布时间 | 主要特点 |

|---|---|---|

TPU v4 |

2022年 | 奠定超大规模集群基础,首个实现超大规模集群共享内存 |

TPU v5 |

2023年 | 优化矩阵乘法,加速深度学习训练 |

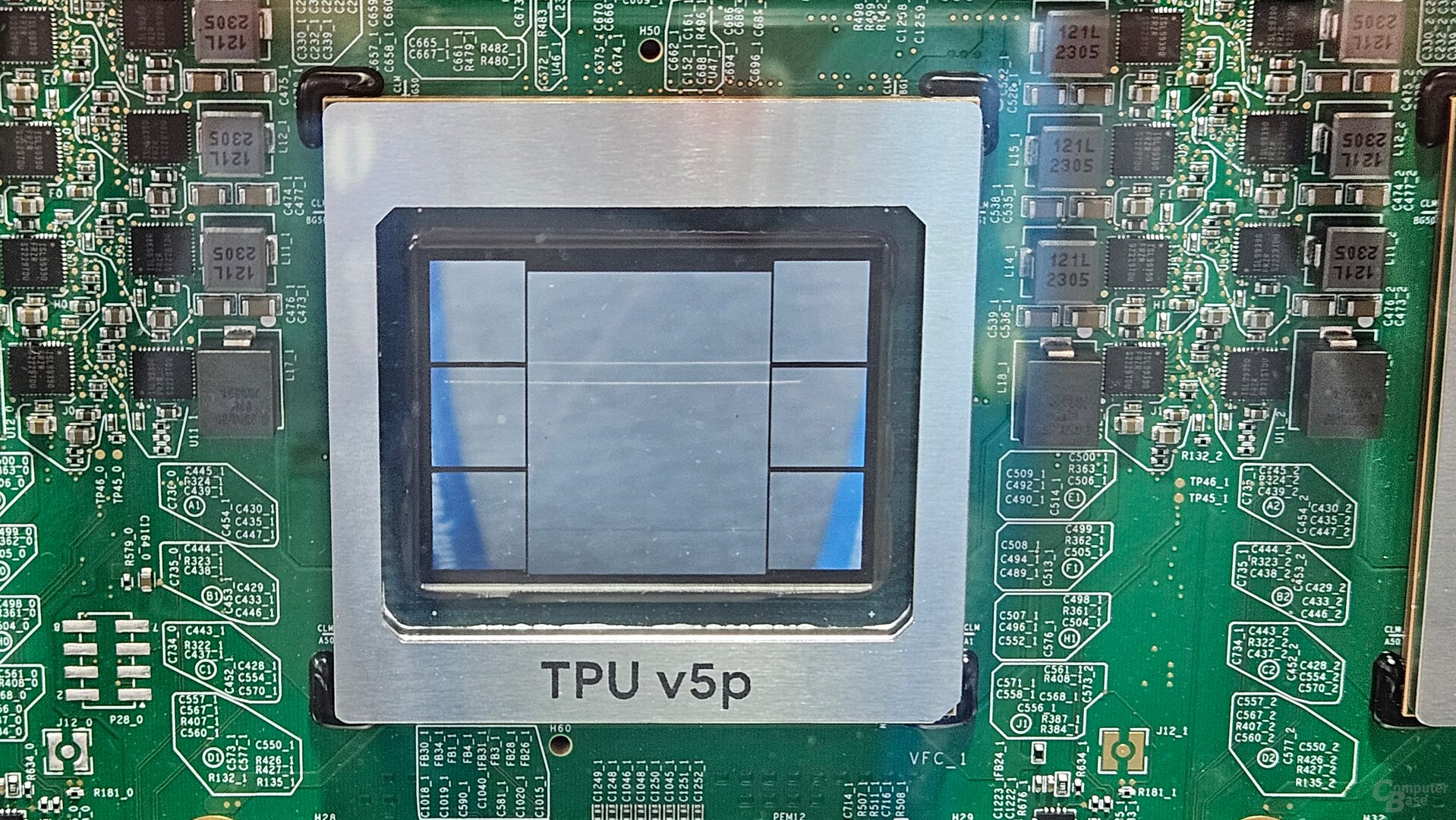

TPU v5p |

2024年 | 专用于训练规模最大、要求最高的生成式AI模型 |

TPU v6 Trillium |

2025年 | 主打能效比和针对AI大型模型的优化 |

TPU Ironwood (v7) |

2025年4月 | 第七代TPU,专为AI推理设计,单芯片峰值算力达4,614 TFLOPs |

- 2025年大规模出货:据行业报道,谷歌TPU在2025年已实现大规模出货[1]

- 市场份额突破:谷歌TPU在全球ASIC AI芯片市场的市占率已突破74%[1]

- 双供应链布局:谷歌从原先与博通(Broadcom)的单一合作模式,转为与**联发科(MediaTek)**合作,形成双供应链布局[2]

- 产能持续扩大:台系厂商已切入北美云厂商的ASIC设计服务供应链,并有望扩大份额

- 谷歌正计划与联发科合作开发下一代AI芯片,预计2026年开始生产[3]

- 与博通的洽谈仍在继续,计划继续共同设计部分TPU芯片

| 指标 | TPU v5p | TPU v4 |

|---|---|---|

高带宽内存(HBM) |

95GB | 32GB |

互连带宽 |

4,800Gbps | - |

训练性能 |

比v4快 2.8倍 |

- |

制程工艺 |

5nm | 7nm |

| 指标 | TPU v5p |

NVIDIA H100 |

|---|---|---|

高带宽内存 |

95GB HBM | 80GB HBM3 |

内存带宽 |

4,800Gbps | 3.35TB/s |

CUDA核心 |

专用脉动阵列 | 16,896个CUDA核心 |

Tensor核心 |

- | 528个 |

制程工艺 |

5nm | 4nm Hopper架构 |

- NVIDIA H100系统(11,616个H100):GPT-3训练任务用时3.44分钟

- TPU v5p系统(6,144个TPU v5p):GPT-3训练任务用时11.77分钟

从测试结果看,H100在大规模集群训练任务中仍保持优势。但TPU v5p具有以下独特优势:

- 单芯片HBM容量:TPU v5p拥有95GB HBM,显著高于H100的80GB

- 高带宽互连:单个TPU pod可提供4,800Gbps的吞吐量

- 能效表现:TPU v6 Trillium主打能效比,针对AI大型模型进行了专门优化

- 专用性:专为深度学习张量运算优化,采用脉动阵列架构加速稠密矩阵乘法

- 软件生态:谷歌开发了"TorchTUA项目",旨在使TPU与PyTorch更加兼容[4]

- 通用性:依托数千个可编程CUDA核心,兼顾图形渲染、科学计算及AI等多多样化场景

- 生态成熟:CUDA生态成熟,支持广泛的深度学习框架

| 成本项目 | NVIDIA H100 | TPU v5p |

|---|---|---|

芯片制造成本 |

约3,000美元 | 未公开 |

市价 |

25,000-35,000美元 | Google Cloud租赁 |

毛利率 |

约90% | 相对更低 |

- TPU成本优势:Google的TPU在云服务租赁方面价格策略更具优势[5]

- API价格对比:Google的Gemini 2.5 Pro API价格比OpenAI o3更具竞争力

- 总体拥有成本(TCO):TPU在特定深度学习任务上的性价比更高

-

资本支出降低:

- 企业无需以2-3.5万美元的高价采购H100

- 可通过Google Cloud按需使用TPU资源

-

运营效率:

- TPU与TensorFlow深度优化,训练特定模型时效率更高

- 谷歌声称TPU成本仅为OpenAI的五分之一[5]

- 大规模深度学习训练:特别是基于TensorFlow的模型

- 成本敏感型项目:需要控制AI基础设施投入的企业

- 特定推理任务:TPU v7 Ironwood专为AI推理设计

- 通用AI开发:需要兼容多种框架和工具链

- 大规模分布式训练:MLPerf测试显示H100在超大规模训练中表现更优

- 需要CUDA生态:依赖NVIDIA丰富的开发工具和库

-

市场格局变化:

- "去英伟达化"趋势加速,科技巨头纷纷自研ASIC芯片

- 预计2025年TPU v6 Trillium将大幅取代现有TPU v5

-

技术发展方向:

- 专用AI芯片与通用GPU的界限日益模糊

- 能效比和成本效益成为竞争焦点

-

供应链演变:

- 双供应链模式降低供应风险

- 产能扩张将持续推动价格下降

[1] 网易 - “ASIC行业观察:谷歌TPU市占率突破74%” (https://www.163.com/dy/article/JQCD6FII0519QIKK.html)

[2] 电子工程专辑 - “研报AI芯片自主化进程加速,云端巨头竞相自研ASIC” (https://www.eet-china.com/mp/a404873.html)

[3] icspec - “谷歌拟联手联发科开发次世代AI芯片,预计2026年投产” (https://www.icspec.com/news/article-details/2424203)

[4] TechInformed - “Google moves to make TPUs feel native to PyTorch” (https://techinformed.com/google-moves-to-make-tpus-feel-native-to-pytorch-as-it-targets-nvidias-cuda-advantage/)

[5] 今日头条 - “Google TPU成本仅为OpenAI五分之一” (https://www.toutiao.com/article/7503863007638733375/)

数据基于历史,不代表未来趋势;仅供投资者参考,不构成投资建议

关于我们:Ginlix AI 是由真实数据驱动的 AI 投资助手,将先进的人工智能与专业金融数据库相结合,提供可验证的、基于事实的答案。请使用下方的聊天框提出任何金融问题。