BabyVision评测集发布对国内多模态大模型竞争格局的影响及xbench布局策略分析

解锁更多功能

登录后即可使用AI智能分析、深度投研报告等高级功能

关于我们:Ginlix AI 是由真实数据驱动的 AI 投资助手,将先进的人工智能与专业金融数据库相结合,提供可验证的、基于事实的答案。请使用下方的聊天框提出任何金融问题。

2026年1月12日,红杉中国xbench携手UniPat AI团队,联合多家大模型公司与高校研究员,正式发布了多模态理解评测集BabyVision[1]。这一评测集的发布源于一个关键的行业洞察:尽管大模型在语言与文本推理方面突飞猛进,能够撰写论文、攻克难题、在顶级学术竞赛中屡创佳绩,但当问题无法"用语言说清楚"时,模型能否真正"看懂"世界仍存在显著疑问[1]。

BabyVision评测集的设计理念聚焦于量化那些"人类直觉就会、但构成智能地基"的视觉原子能力。评测将视觉能力划分为四大类共22个子任务[1][2]:

| 能力类别 | 核心能力描述 | 子任务数量 |

|---|---|---|

| 精细辨别 | 细粒度视觉信息提取与区分 | 9个子任务 |

| 视觉追踪 | 运动轨迹与连通性识别 | 4个子任务 |

| 空间感知 | 三维结构及其关系的理解 | 5个子任务 |

| 视觉模式识别 | 逻辑与几何规律的识别 | 4个子任务 |

这一评测体系的独特之处在于,它最大程度控制了语言依赖,确保题目要求简单但答案必须依靠视觉信息本身得出,从而有效检验模型的真实视觉能力[2]。

BabyVision评测结果揭示了当前多模态大模型在视觉基础能力方面的显著不足,整体表现甚至落在"三岁幼儿"水平区间[1][2]。具体评测结果如下:

- Gemini 3-Pro-Preview:49.7%(最强)

- GPT-5.2:34.8%

- Doubao-1.8:30.2%[2]

- Qwen3VL-235B-Thinking:22.2%(最强)

- 多数模型集中在12%-19%区间[2]

更引人注目的是BabyVision-Mini小试卷实验:研究团队将20道视觉中心任务交给不同年龄段孩子(3/6/10/12岁)和顶尖多模态模型同时测试,结果显示大多数模型的分数明显低于平均3岁儿童的水平,Gemini 3-Pro-Preview是唯一稳定超过3岁基线的模型,但仍距离6岁儿童约20个百分点[1]。

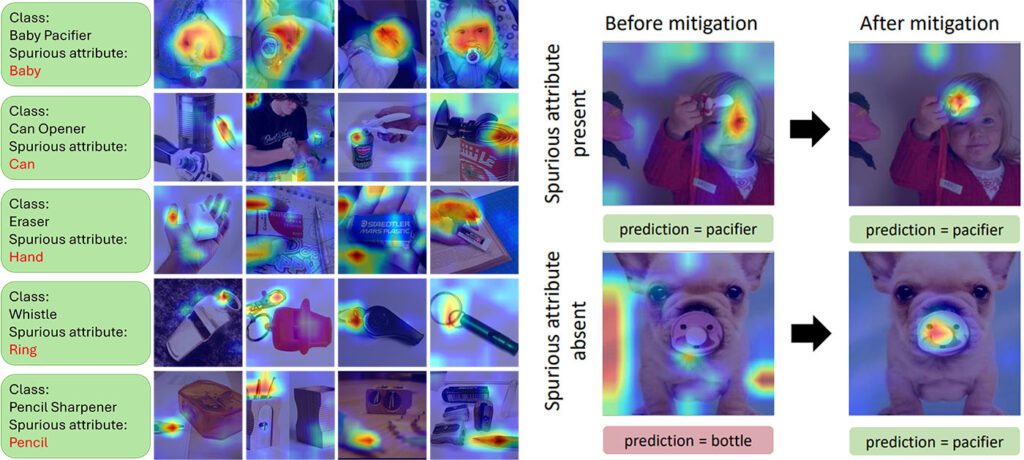

BabyVision评测集的发布为国内多模态大模型竞争格局带来了深远影响。首先,它明确指出了当前多模态大模型的核心短板——"unspeakable"问题[2]:视觉细节难以无损压缩成token,模型一旦走先复述再推理的语言捷径,关键信息会在压缩中丢失。这一发现揭示了模型在非语言细节辨别、视觉追踪、空间想象、图形规律归纳四大类基础视觉能力上存在系统性缺陷[1][2]。

传统的多模态评测往往侧重于模型的"会说会写"能力,而BabyVision的发布将竞争焦点转移到了"真实视觉理解"层面。这对于国内多模态大模型厂商而言,意味着单纯的语言推理能力已不足以构建竞争壁垒,视觉地基能力的补齐将成为下一阶段竞争的关键。

评测集的核心设计理念直接服务于具身智能(embodied AI)走向现实世界的需求[2]。由于真实世界不靠语言提示运行,视觉基础能力成为具身智能的必修课。BabyVision将"看懂世界"拆解为可测量、可诊断、可迭代的22个原子能力,为具身智能的技术突破提供了关键的评测标准和发展路线图[1]。

BabyVision提出了"让模型画出来"的生成式作答新方向[1][2]。BabyVision-Gen从基准中重标注280道适合生成式作答的题,要求模型用图像/视频输出解题过程。实验结果显示,自动评测与人工一致性达96%,且在追踪、精细辨别等任务上更接近人类操作。这为行业提供了新的研究思路:视觉推理"落地到视觉操作"可能是补齐多模态大模型视觉短板的有效路径[2]。

xbench采用双轨评估体系,将评估基准划分为AGI Tracking赛道与Profession Aligned赛道[1][2]:

| 轨道 | 定位 | 目标 |

|---|---|---|

| AGI Tracking | 追踪模型的AGI演进进程 | 评估AI系统的能力上限与技术边界 |

| Profession Aligned | 量化模型在真实世界中的经济与实用价值 | 评估AI系统在真实场景的效用价值 |

BabyVision属于xbench双轨评估中AGI Tracking系列的多模态评估集。展望2026年,xbench判断世界模型与视觉多模态将迎来新一轮突破性进展,值此开年之际发布BabyVision,正是为了迎接并参与新一轮技术突破[1]。

xbench采用长青评估(Evergreen Evaluation)机制[3]:

- 持续更新维护:xbench-ScienceQA和xbench-DeepSearch均采用每月更新榜单、每季度至少更新一次评估集的方式,保证评测集的时效性

- 黑白盒防污染机制:公开开源评测集的同时,内部维护闭源的黑盒版本;若开源与闭源版本的模型排名相差较大,会从榜单中移除相关排名和分数,避免刷榜和评测集污染[3]

xbench针对不同应用场景进行了精准布局[3]:

| 场景 | 评测集 | 核心考察能力 | 目标用户 |

|---|---|---|---|

| 基座模型 | xbench-ScienceQA | 专业知识与推理能力 | 大模型研究者 |

| AI Agent | xbench-DeepSearch | 规划+搜索+推理+总结的端到端深度搜索能力 | AI Agent开发者 |

| 多模态 | BabyVision | 真实视觉理解能力 | 多模态模型开发者 |

| 垂直领域 | Profession-Recruitment/ Marketing | 特定领域的Agent能力 | 垂直行业开发者 |

xbench选择开源xbench-ScienceQA和xbench-DeepSearch两个核心评测集,吸引海内外大厂、创业公司、研究者等参与生态建设[3]。同时开放提测、题目共建等渠道,欢迎通过team@xbench.org参与生态建设。这一策略旨在依托社群力量推动评测集持续进化,确保评测体系始终保持前沿性和有效性。

xbench的布局策略具有明确的补位意识[3]:

- 针对经典学科评测集已接近满分、无法度量模型进展的问题,推出xbench-ScienceQA,聚焦STEM学科的高难度、高区分度评测

- 针对研究生水平评测集数量少、更新难的问题,持续维护并动态更新评估内容

- 针对业界缺乏高质量AI Agent深度搜索能力评测集的现状,推出xbench-DeepSearch,填补中文语境下Agent深度搜索评测的空白

BabyVision评测集的发布标志着国内多模态大模型评测进入了新阶段。从竞争格局角度看,这一评测集将促使各大模型厂商重新审视自身的视觉能力短板,将研发资源从单纯的语言推理能力扩展到真实视觉理解层面。从技术发展角度看,"unspeakable"问题的提出和"让模型画出来"的新方向为行业提供了明确的优化路线图。

红杉中国xbench通过双轨评估体系、长青评估机制和开源共创生态的系统性布局,正在构建一个覆盖基座模型、AI Agent、多模态理解和垂直领域的全方位评测体系。这一体系不仅服务于当下的模型能力评估,更为即将到来的世界模型与视觉多模态新一轮突破做好铺垫。随着2026年AI行业对具身智能和世界模型关注度的持续提升,xbench的评测布局将在行业发展中发挥更加关键的引导作用。

[1] 新浪财经 - “多模态大模型输给三岁宝宝?xbench x UniPat联合发布新评测集BabyVision” (https://finance.sina.com.cn/chanjing/gsnews/2026-01-12/doc-inhfzcnv8496112.shtml)

[2] UniPat AI Blog - “BabyVision评测集发布” (https://unipat.ai/blog/BabyVision)

[3] 红杉中国官网 - “xbench评测集正式开源” (https://www.hongshan.com/article/xbench评测集正式开源/)

数据基于历史,不代表未来趋势;仅供投资者参考,不构成投资建议

关于我们:Ginlix AI 是由真实数据驱动的 AI 投资助手,将先进的人工智能与专业金融数据库相结合,提供可验证的、基于事实的答案。请使用下方的聊天框提出任何金融问题。